这个春节最火的话题DeepSeek当之无愧。

如果在使用 DeepSeek 过程中,经常遇到 "服务器繁忙" 的提示,是不是感到很头疼?明明手上有强大的 AI 模型,却因为服务器压力或网络问题,体验大打折扣。

其实,我们完全可以把 DeepSeek 部署到本地,结合 Ollama 和 Chatbox,打造一个流畅、稳定、可私有化的 AI 聊天助手,不再受限于服务器的响应速度。本篇文章将详细介绍如何实现这一目标,让你的 AI 随时待命,畅聊无阻!

本地化部署意味着我们的数据不需要传输到远程服务器,这为数据隐私提供了更强的保障。同时对于一些实时性要求较高的应用,本地化部署可以显著降低响应时间,提供更快的服务,特别是对需要即时反馈的任务。

如何进行本地化部署DeepSeek?

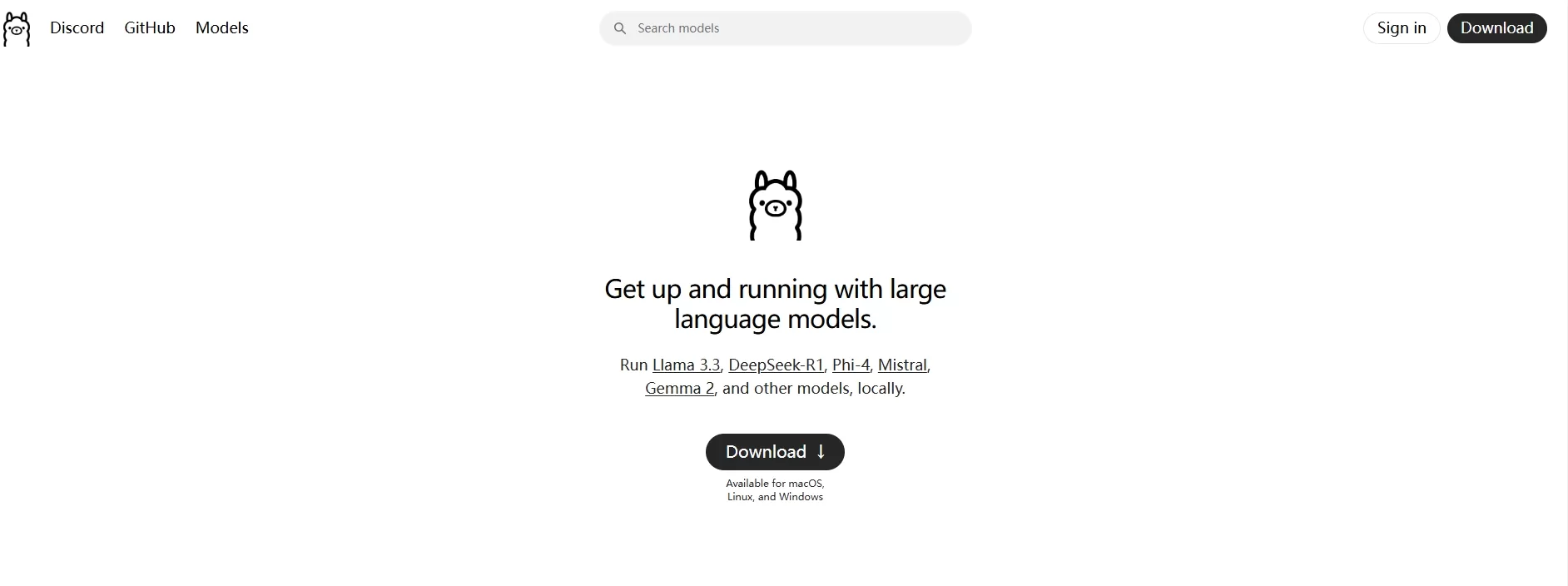

打开Ollama官网点击下载(根据个人电脑系统情况进行选择下载);

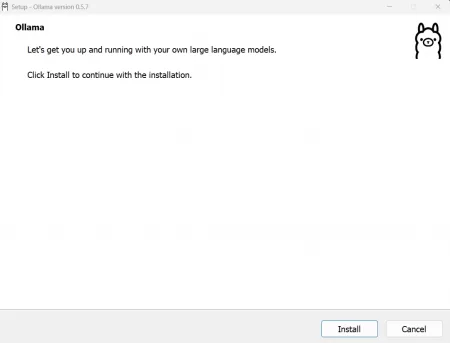

下载完成后我们点击软件图标进行安装;

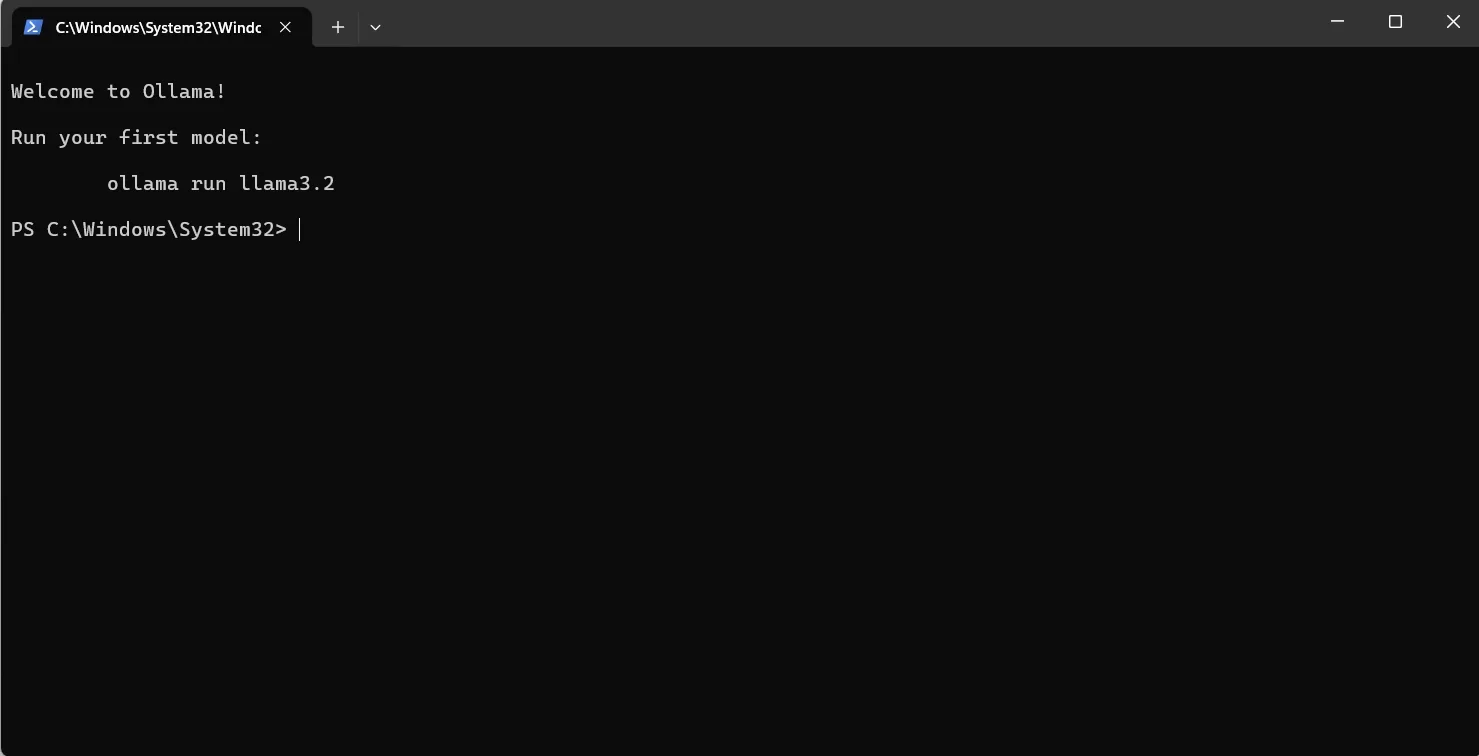

安装完成后会自动弹窗CMD的窗口(如果没弹出,Win+R在输入CMD即可),

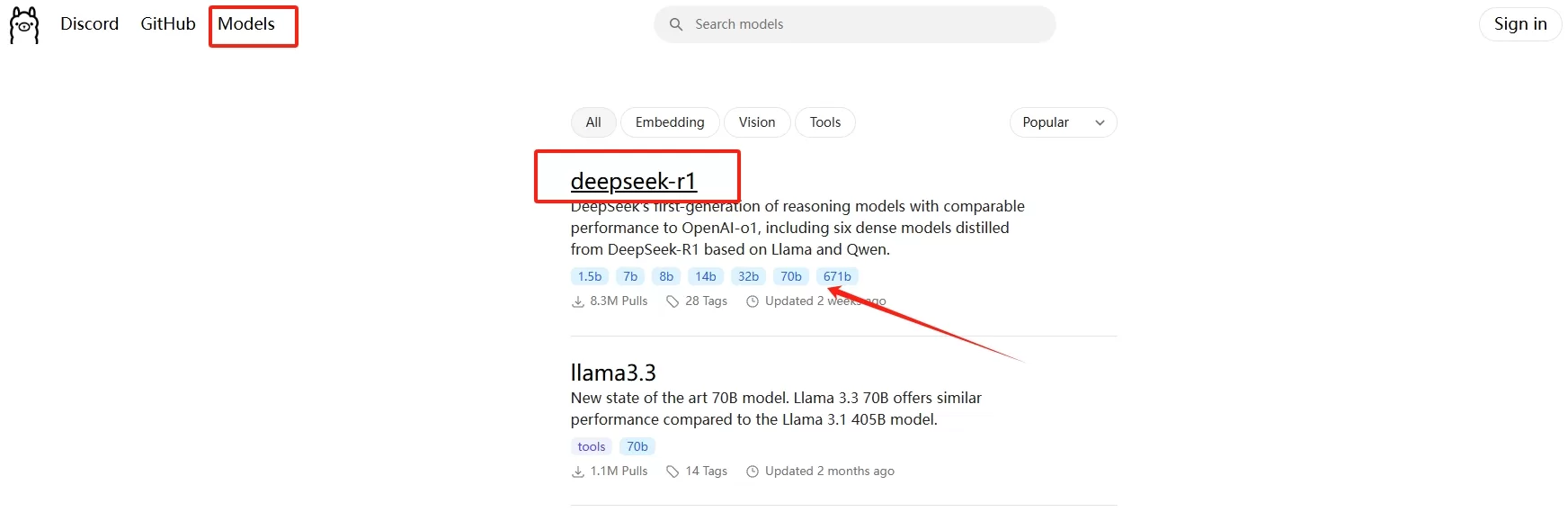

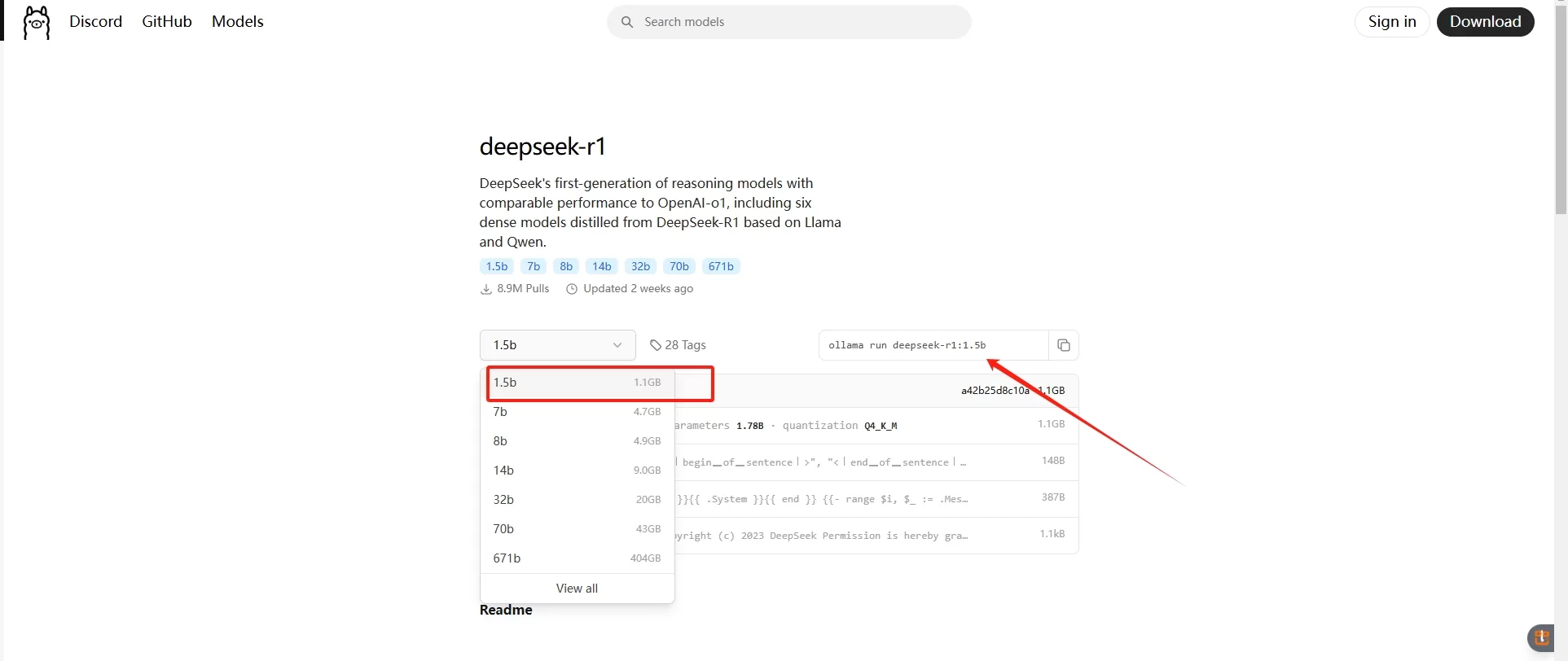

返回Ollama官网,点击“Models”选择“deepseek-r1”;我们可以看到描述下面有1.5b、7b、8b一直到671b这类数值规格显示,数值越大,说明提供的服务性能就越强,相对电脑的性能要求就越高,我们一般办公处理的电脑选择最低1.5b的就可以,

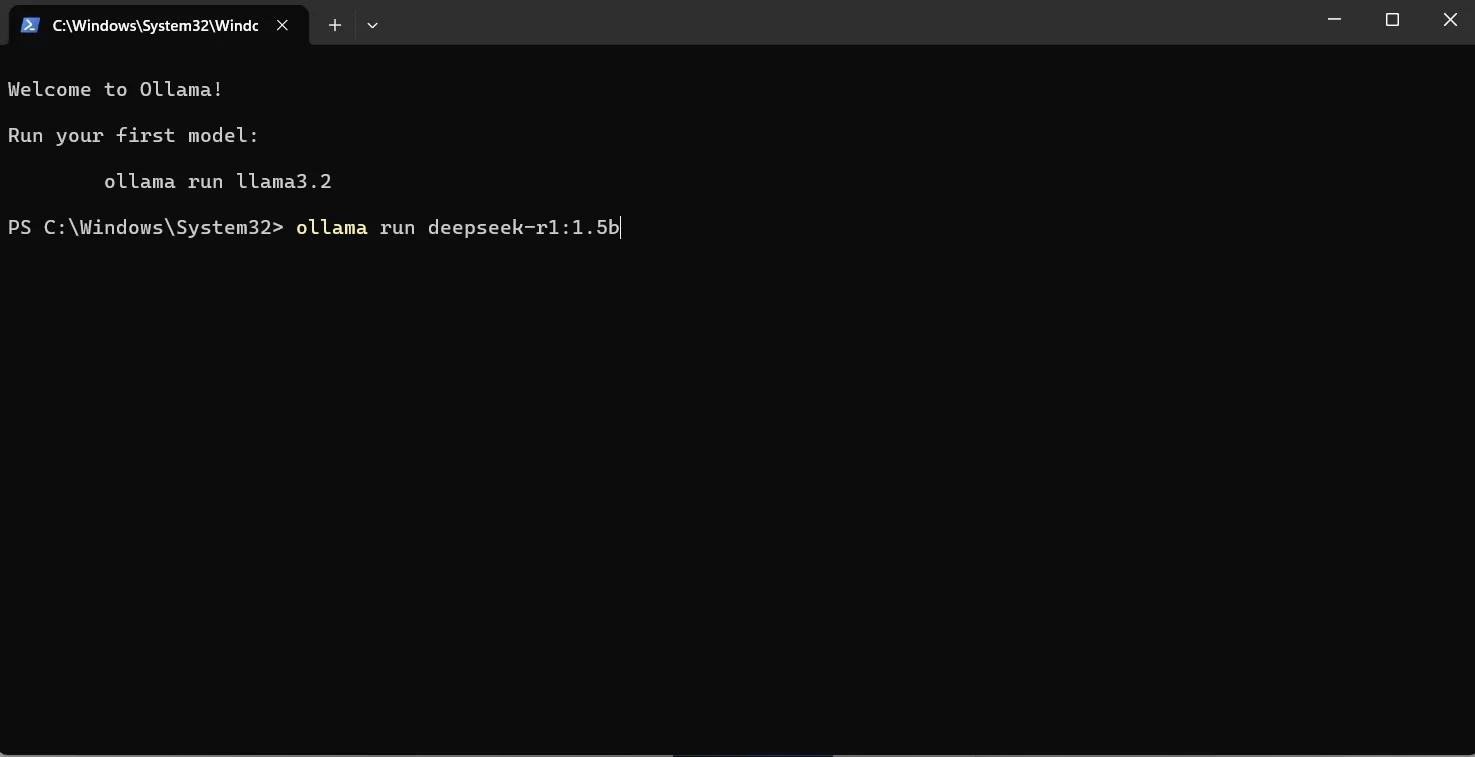

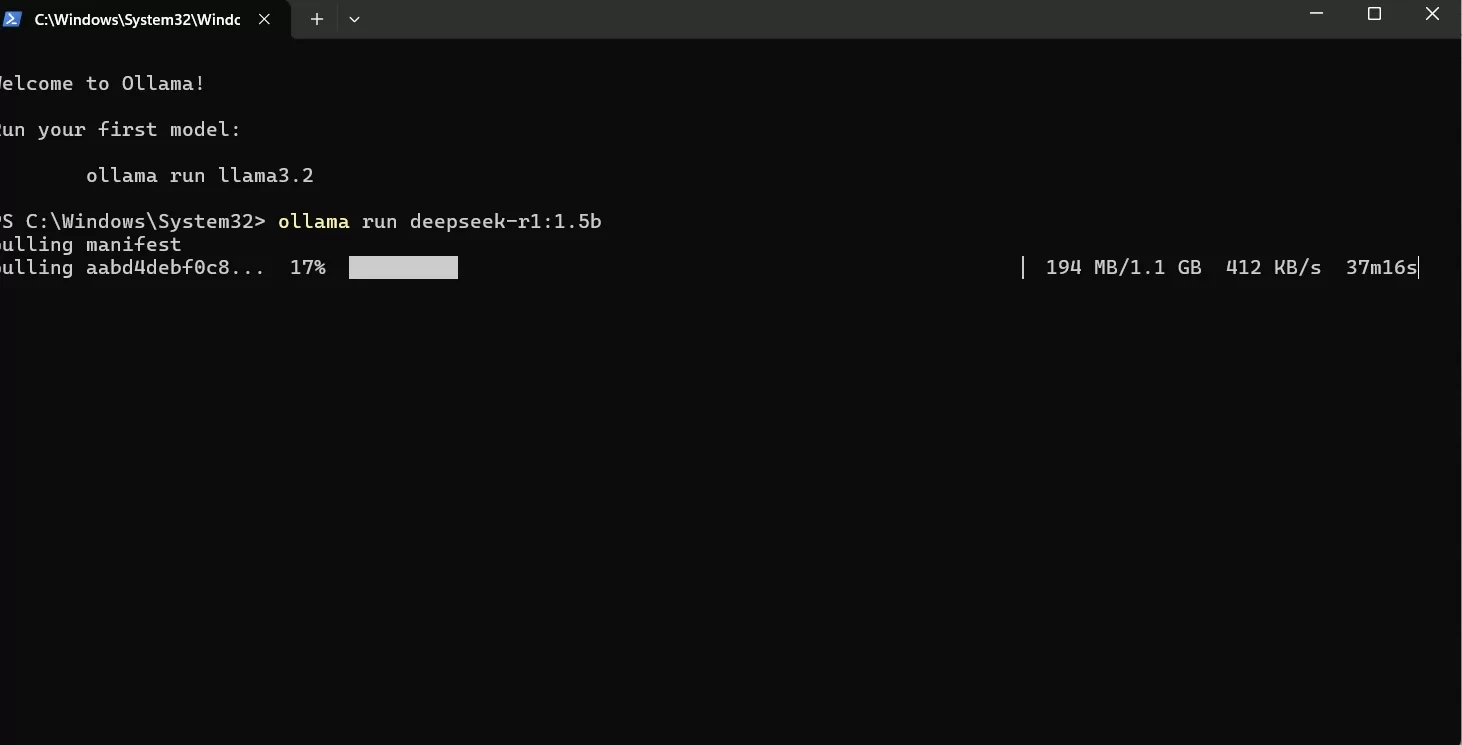

点击选择1.5b, 并且复制右边这行代码 “ollama run deepseek-r1:1.5b”;

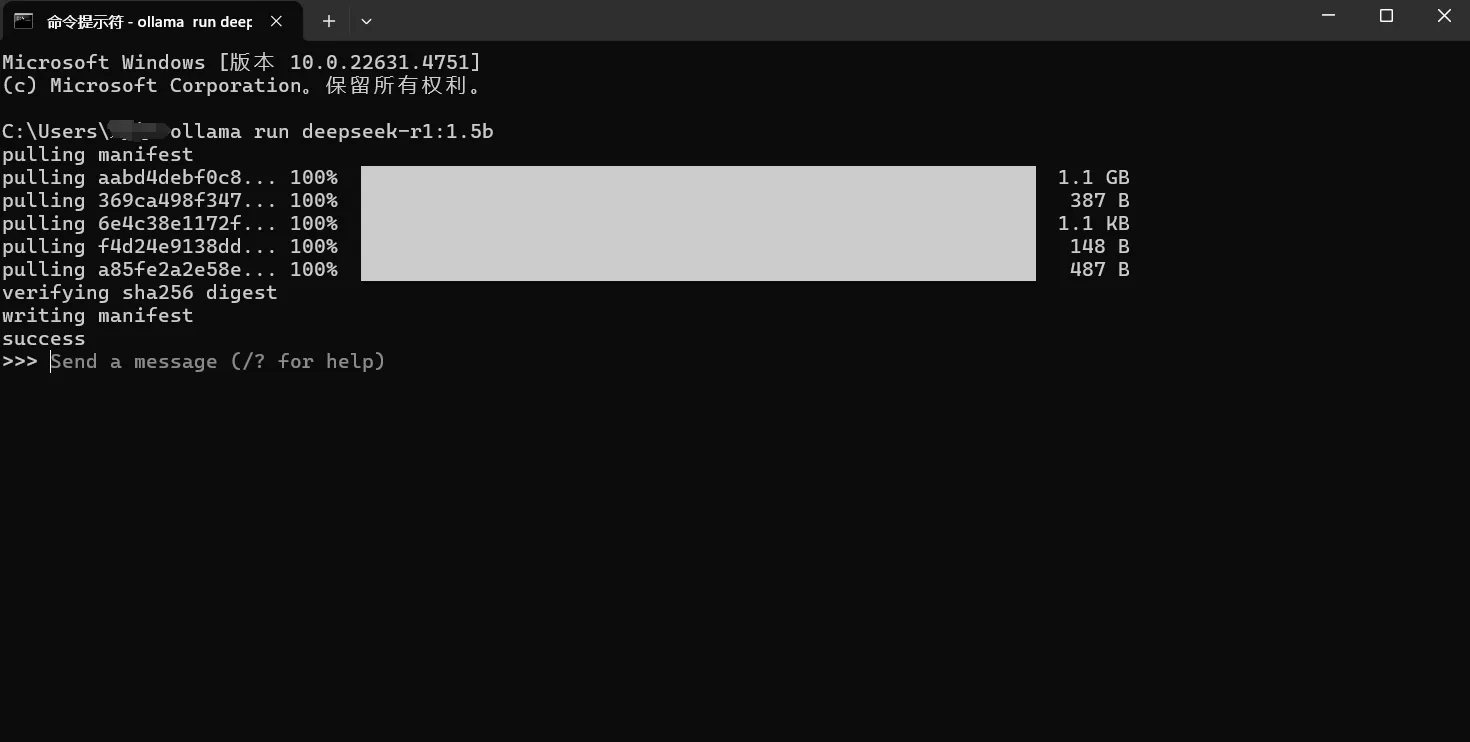

返回之前窗口复制代码:“ollama run deepseek-r1:1.5b” 按回车键;下载DeepSeek大模型

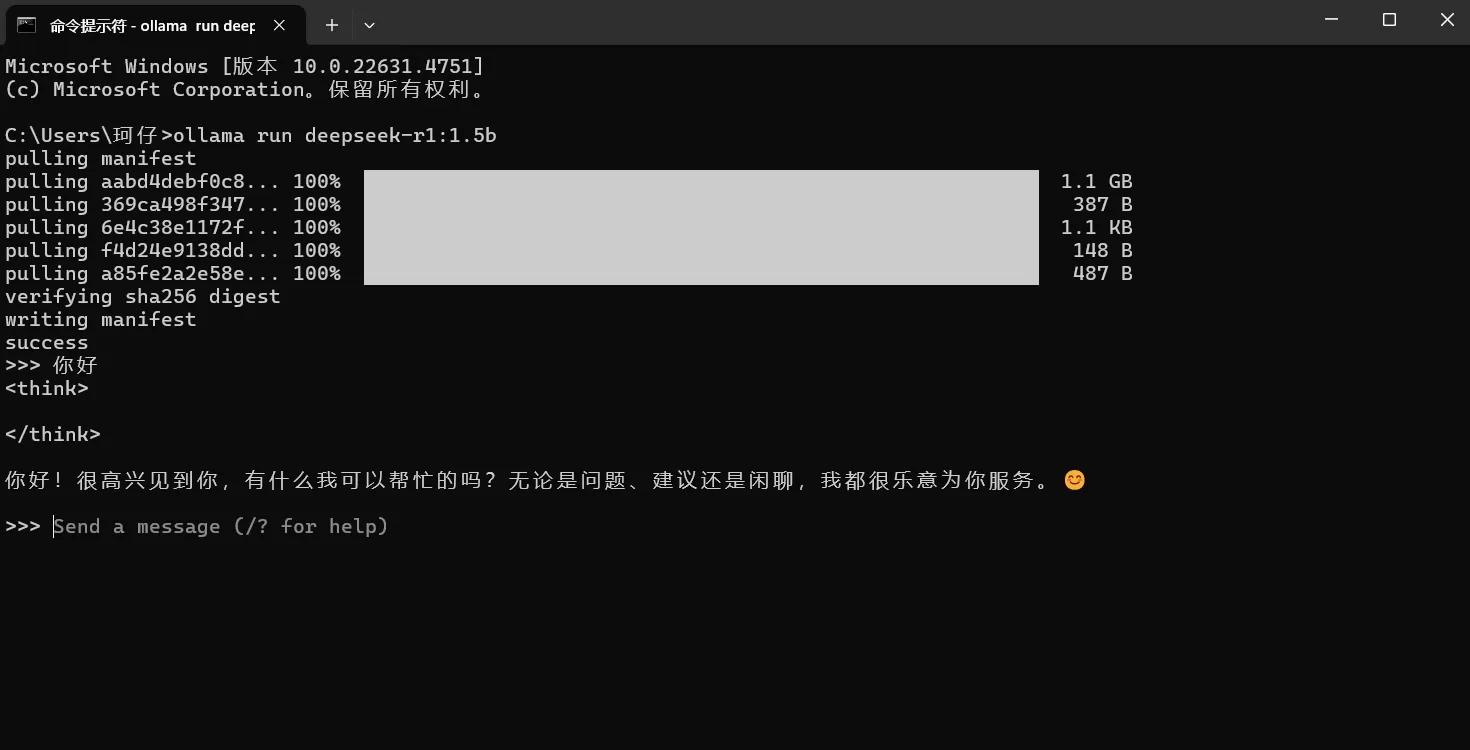

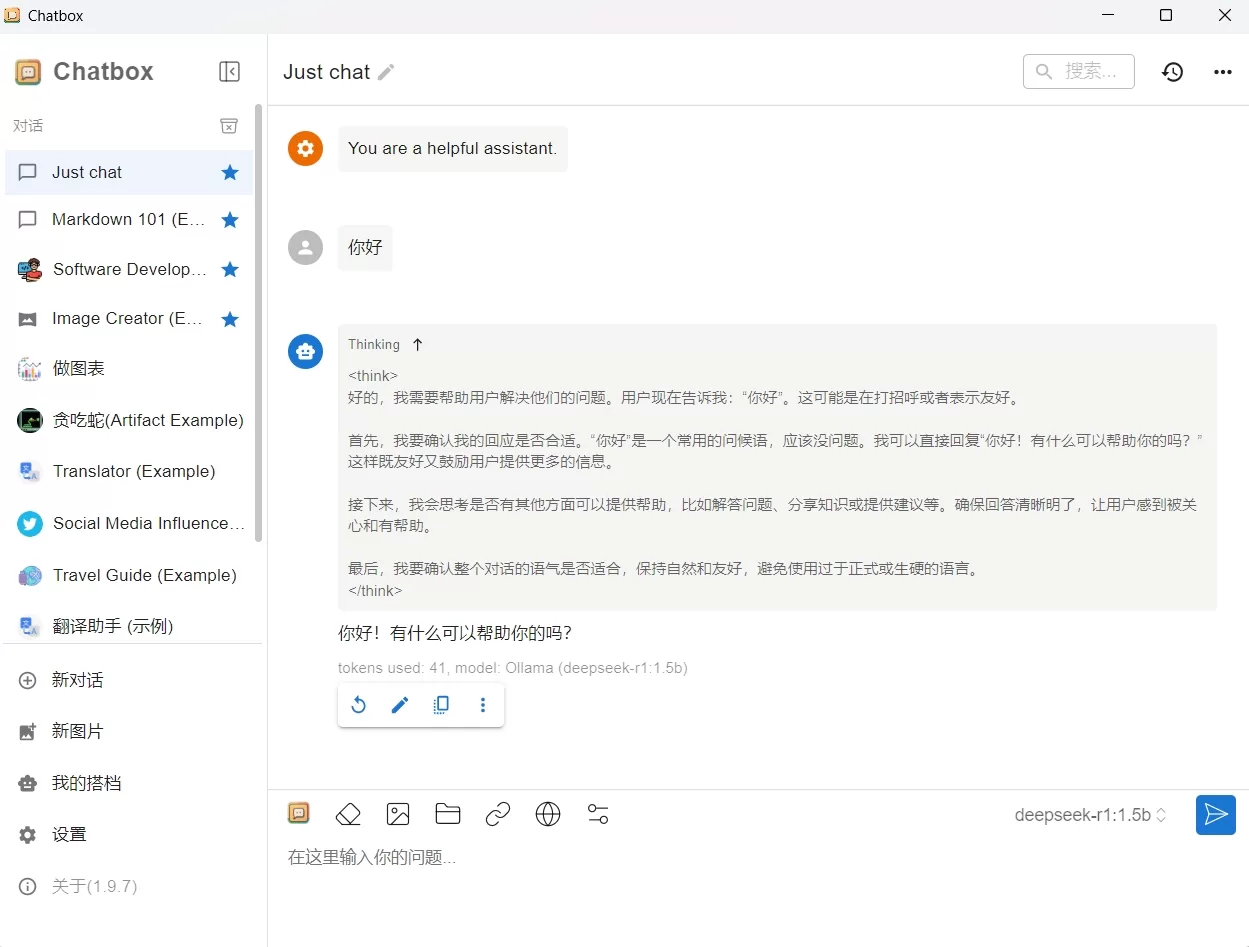

配置成功提示如上图;我们可以使用下看下效果,可以发现目前的可视化窗口不太友好,每次使用都要启动代码,相对来说会比较麻烦。我们可以搭配一个可视化窗口 - Chatbox 一起使用

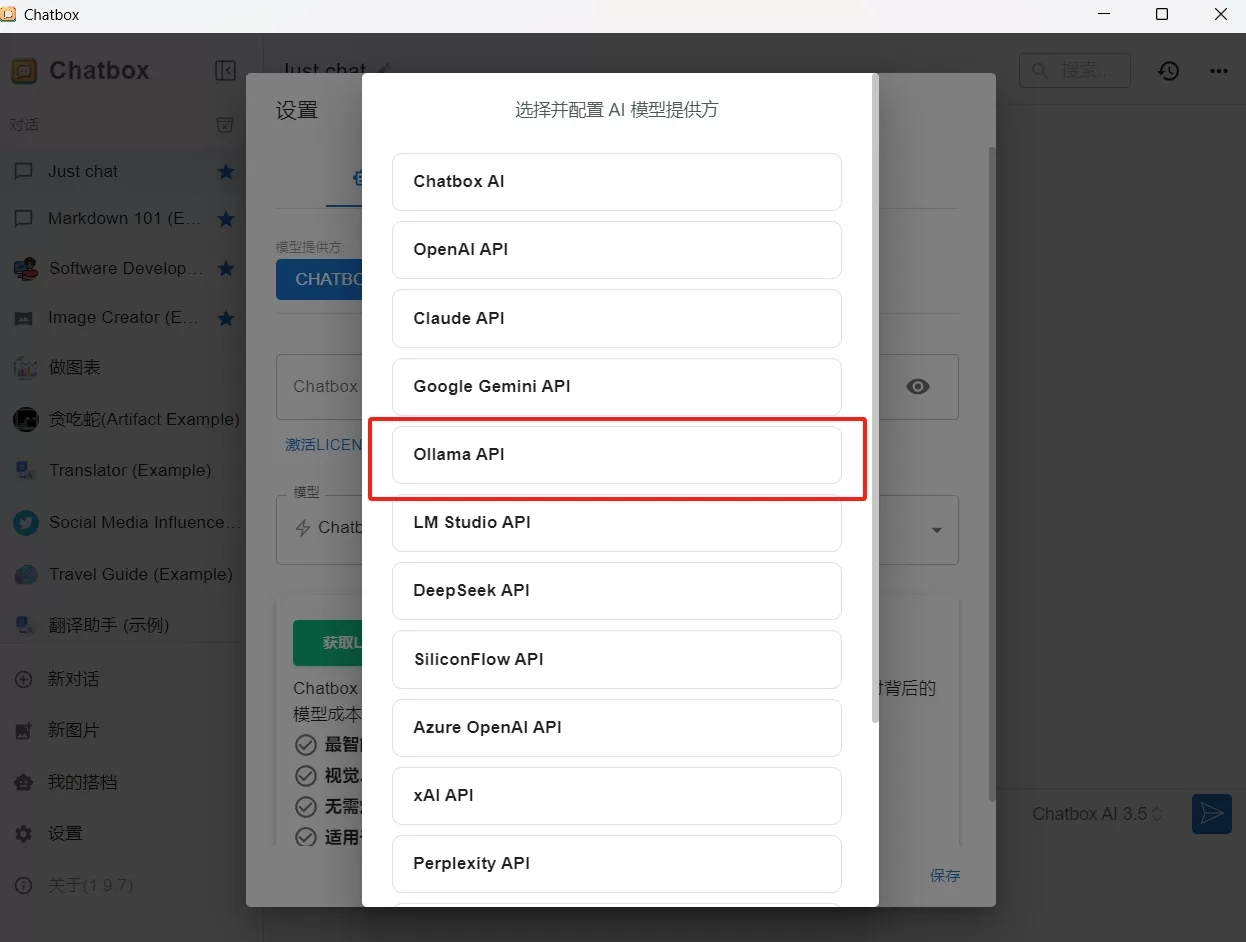

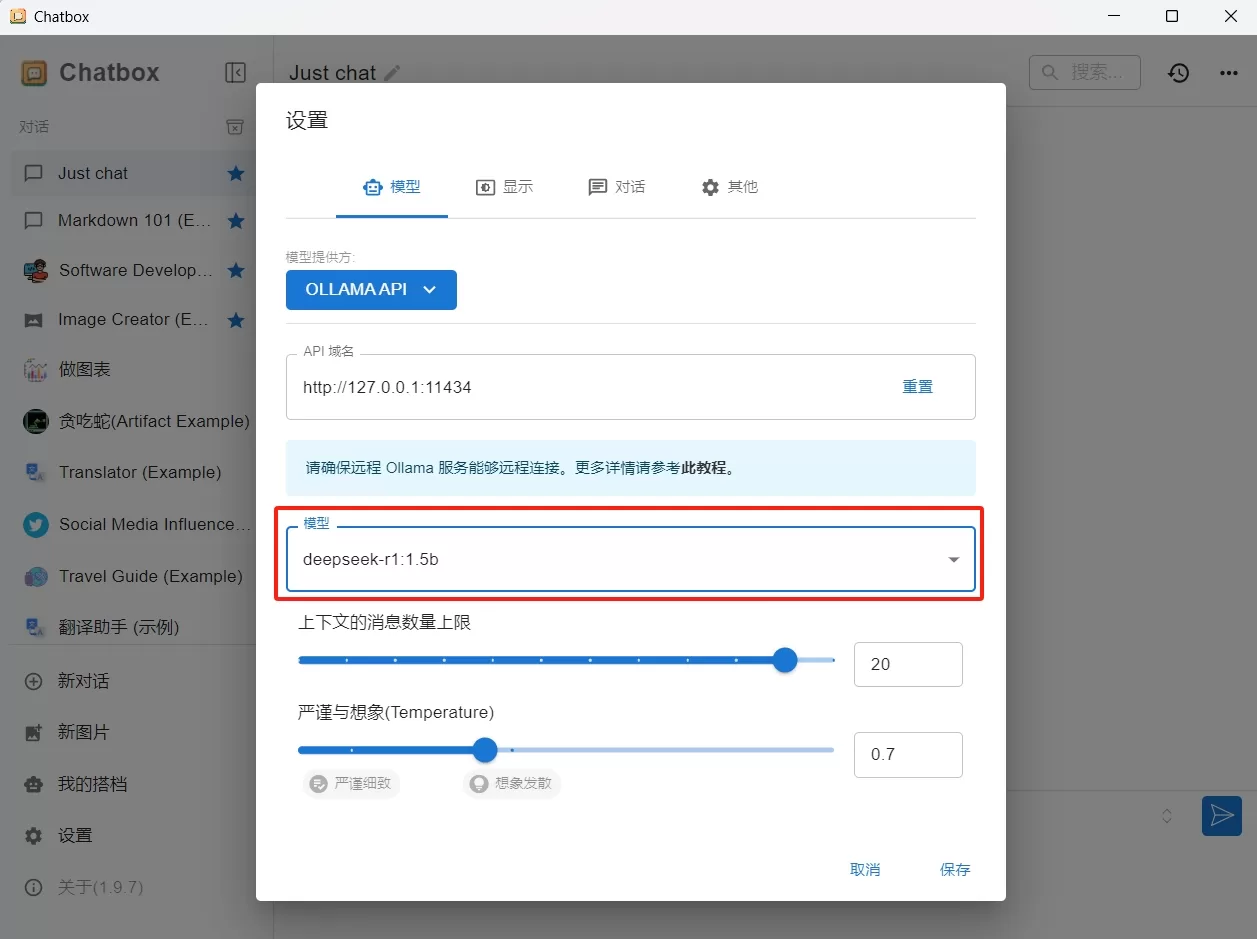

下载完成后,打开“Chatbox”,进入“设置”,“模型提供方”选择“Ollama API”, “模型”选择已经下载好的“deepseek-r1:1.5b”, 点击“保存”,这时我们就可以调用“Chatbox”这个工具来使用DeepSeek。

通过本地化部署 DeepSeek,并结合 Ollama 和 Chatbox,我们成功绕开了服务器繁忙的问题,实现了更稳定、更快速、更私密的 AI 体验。无论是日常交流还是专业应用,本地部署都能带来更高的自由度和可控性。

以上。

更多关于独立站运营、谷歌SEO、谷歌广告、海外社媒和站外推广方面知识欢迎关注跨境品牌说。

欢迎关注微信公众号:跨境品牌说

打卡学习

打卡学习